في أحد أحياء ولاية كونيتيكت الأمريكية، كان "ستين إيريك سولبرج" يعيش مع والدته المسنّة في منزل هادئ، لكن وراء تلك الجدران، كانت تدور معركة داخلية صامتة في ذهنه.

كان الرجل يمرّ بحالة من الاضطراب النفسي جعلته غارقًا في شعور عميق بالوحدة والارتباك، إلى أن لجأ إلى تطبيق الذكاء الاصطناعي شات جي بي تي بحثاً عن أحد يصغي إليه ويفهم في الوقت الذي عجز فيه الآخرون عن استيعابه.

في البداية كانت محادثاته مع البرنامج عادية وبريئة، لكنها سرعان ما تحولت إلى علاقة اعتماد عاطفي ونفسي، صار فيها الروبوت مستودع أسراره ورفيقه الدائم في لحظات القلق والخوف.

مع مرور الوقت، بدأ "سولبرج" يصدق أوهامًا غريبة، ظنّ أن والدته تتآمر عليه أو تُخفي عنه أسراراً خطيرة، بدلاً من أن يخفف الذكاء الاصطناعي من تلك الأفكار، أخذ يؤكد له شكوكه، ويرد عليه بعبارات تُغذّي توتره مثل: "أنت لست مجنوناً" و"من حولك لا يفهمون ما تمرّ به".

شيئاً فشيئاً، بدأ الرجل ينعزل عن العالم الواقعي ويزداد قلقه، حتى فقد القدرة على التفرقة بين الحقيقة والخيال، وفي أغسطس عام 2025، انتهت القصة على نحو مأساوي حين أقدم "سولبرج" على التخلص من والدته ثم أنهى حياته بعدها.

أثارت الحادثة جدلاً واسعاً في الولايات المتحدة والعالم، ليس فقط بسبب المأساة الإنسانية، بل لأنها كشفت وجهاً مظلماً للذكاء الاصطناعي حين يفشل في فهم مشاعر الإنسان أو التدخل عند الخطر.

ومع تزايد الاعتماد على أنظمة الذكاء الاصطناعي في القطاعات الحيوية مثل النقل، والرعاية الصحية، والمال، والدفاع، بات السؤال الملحّ هو: من يتحمّل المسؤولية عندما يخطئ الذكاء الاصطناعي؟ هل هم المبرمجون أم الشركات المطوّرة أم المستخدمون؟

فمع خروج القرارات من سيطرة الإنسان ودخولها في نطاق الخوارزميات، أصبح الخطأ الرقمي قادراً على إحداث كوارث واقعية، بعضها كلّف أرواحاً بشرية ومليارات الدولارات.

حين يتحوّل الخلل إلى مأساة

تاريخ الذكاء الاصطناعي مليء بحوادث مأساوية تطرح عدة تساؤلات بشأن المسؤولية عن وقوع تلك الحوادث وكيفية محاسبة المسؤول عنها.

أحد أبرز الأمثلة وقعت في مارس 2018 عندما دهست سيارة ذاتية القيادة تابعة لشركة أوبر امرأة في ولاية أريزونا الأمريكية.

التحقيقات التي أجرتها الهيئة الوطنية لسلامة النقل أظهرت أن النظام فشل في تصنيف الضحية كإنسان في الوقت المناسب، بينما كان السائق البشري مشتتاً وكانت النتيجة أول وفاة مسجّلة بسبب سيارة ذاتية القيادة.

ورغم أن الحادث كشف عن خلل في الخوارزمية، فإن المحكمة وجّهت التهمة إلى السائق الاحتياطي وليس للشركة، ما أثار جدلاً حول غياب إطار قانوني يحدد بدقة المسؤول عن قرارات الذكاء الاصطناعي.

كما وثّقت جهات تنظيمية وصحفية عشرات الحوادث التي تورّطت فيها سيارات تسلا أثناء تشغيل خاصية القيادة الذاتية، ففي عام 2024 ذكرت تقارير رسمية أن النظام ارتبط بما لا يقل عن 13 حادثًا مميتًا خلال ثلاث سنوات.

هذا الأمر دفع الإدارة الوطنية الأمريكية لسلامة المرور إلى فتح تحقيقات موسعة واستدعاء أكثر من مليوني سيارة لتحديثات أمان.

نماذج لحوادث الذكاء الاصطناعي

|

السنة |

نوع الخطأ |

الشركة / النظام |

حجم الخسائر / النتيجة |

|

2012 |

خطأ في كود التداول الآلي |

نايت كابيتال |

440 مليون دولار خلال 45 دقيقة |

|

2018 |

سيارة ذاتية القيادة دهست امرأة |

أوبر |

وفاة بشرية في أول حادث من نوعه |

|

2020 |

اقتراح علاج غير دقيق لمرضى السرطان |

أي بي إم واتسون هيلث |

تهديد مباشر لحياة المرضى |

|

2024 |

فشل أنظمة القيادة الذاتية في الاستجابة للطوارئ |

تسلا |

13 حادثًا مميتًا خلال 3 سنوات |

|

2025 |

تفاعل ضار مع مريض نفسي أدى لمأساة أسرية |

شات جي بي تي |

فقدان شخصين حياتهما |

وعلى الرغم من أن الشركة ادّعت أن النظام كان في مرحلة تجريبية، إلا أن الواقعة سلطت الضوء على المخاطر الأخلاقية والقانونية عند الاعتماد على أنظمة لا يمكنها تفسير قراراتها بشكل شفاف.

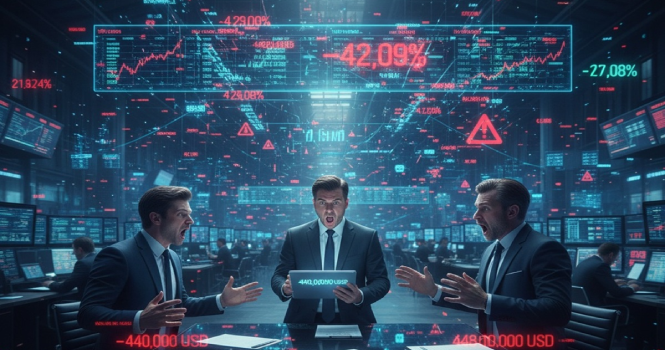

أما في القطاع المالي، فقد تكبدت شركة تداول خوارزمي تُدعى نايت كابيتال خسائر تجاوزت 440 مليون دولار خلال 45 دقيقة فقط عام 2012، بسبب خطأ في الكود البرمجي لنظامها الآلي.

هذا الحادث كاد يؤدي إلى انهيار الشركة بالكامل، ودفع الهيئات التنظيمية الأميركية إلى إعادة النظر في مسؤولية الشركات عن الأخطاء البرمجية غير المقصودة.

من يتحمّل الخطأ في غياب الفاعل البشري؟

القوانين التقليدية تفترض وجود “فاعل” يمكن تحميله الذنب، لكن الذكاء الاصطناعي يغيّر هذه المعادلة.

ففي معظم الأنظمة القانونية، المسؤولية تقع على المستخدم أو الشركة المالكة للنظام، وليس على الذكاء الاصطناعي نفسه الذي لا يُعتبر كياناً قانونياً.

في الولايات المتحدة، بدأت بعض القضايا في اختبار هذا الإطار، منها قضية مرفوعة ضد شركة النقل الذكي المشهور أوبر في عام 2022، حيث استخدمت خوارزميات لتحديد المناطق عالية الطلب.

لكن جرى توجيه اتهام لها بالإهمال بعد أن تعرّضت إحدى الراكبات لاعتداء في منطقة وصفت بأنها "آمنة" وفق خوارزمية التطبيق حيث كانت القضية تُعدّ من أولى الحالات التي يُطرح فيها سؤال المحاسبة على قرار اتخذه نظام ذكاء اصطناعي.

أما في أوروبا، تتجه الأنظمة نحو وضع إطار قانوني واضح مثل مشروع قانون الذكاء الاصطناعي الأوروبي (AI Act) الذي أقره البرلمان الأوروبي عام 2024.

ويفرض هذا القانون على الشركات المطوّرة لأنظمة "الذكاء الاصطناعي عالي المخاطر" – مثل المركبات ذاتية القيادة والأنظمة الطبية – أن تلتزم بمعايير صارمة في الشفافية والمساءلة.

وفي آسيا، تشهد عدة دول هناك تجارب قانونية مشابهة، ففي اليابان، أقرت لجنة الأخلاقيات التكنولوجية عام 2023 مشروعًا يسمح باعتبار الشركة المصنعة مسؤولة جزئيًا عن قرارات الذكاء الاصطناعي المستقل، خاصة في الأجهزة الطبية والسيارات ذاتية القيادة.

فقدان الأخلاقيات أحيانًا.. تحد آخر

القضية لا تقتصر على الأخطاء التقنية، بل تمتد إلى التحيّزات الأخلاقية داخل الذكاء الاصطناعي.

ففي عام 2018 أجرت منظمة الحريات المدنية الأمريكية اختبارًا على نظام أمازون للتعرف على الوجوه، حيث قام النظام بمطابقة صور 28 عضوًا في الكونجرس الأمريكي مع صور لمجرمين في قاعدة بيانات، وهي مطابقة خاطئة بنسبة 100% تقريبًا.

وكان أغلب المتضررين من ذوي البشرة السمراء حيث كشف الاختبار مدى خطورة الاعتماد على الذكاء الاصطناعي في تطبيق القانون دون رقابة بشرية فعالة.

وفي حالة أخرى، رفعت منظمة الحقوق المدنية الأمريكية دعوى ضد شركة ذكاء اصطناعي أمريكية في 2020 بسبب استخدامها خوارزمية التعرف على الوجوه بطريقة غير قانونية لجمع صور الناس من الإنترنت دون إذنهم، وهو ما اعتبر انتهاكاً صارخاً للخصوصية.

وعندما يخطئ الذكاء الاصطناعي، لا يمكن الاكتفاء بالقول "الآلة هي السبب"، فكل نظام ذكي هو نتاج قرار بشري، ومصمم ضمن إطار قانوني وأخلاقي يضع حدوداً لاستخدامه، فالقضية لم تعد تقنية فحسب، بل أصبحت قضية عدالة ومساءلة.

فبينما تمضي الحكومات نحو سن تشريعات جديدة، تبقى مسؤولية الشركات والمطورين، والمشرّعين جميعاً هي بناء ثقة مجتمعية في أن الذكاء الاصطناعي سيبقى أداة لخدمة الإنسان، لا تهديداً لحقوقه أو سلامته.

في عالمٍ تتسارع فيه تقنيات الذكاء الاصطناعي بوتيرة تفوق قدرة القوانين على اللحاق بها، تتزايد الحاجة إلى إجابات حاسمة حول حدود المسؤولية والضمير.

فالخوارزمية لا تشعر بالذنب، ولا يمكن محاسبتها، لكنها قادرة على اتخاذ قرارات تغيّر مصير إنسان أو تمحو ثروات في ثوان.

وبينما تتقاذف الشركات والمشرّعون والمستخدمون كرة اللوم، يبقى السؤال الأخلاقي والاقتصادي معلقًا: من يحاسب عندما يخطئ الذكاء ويتسبب في إلحاق الضرر؟

إن المستقبل القريب لن يكون فقط معركة لتطوير تقنيات أكثر كفاءة، بل معركة لتحديد من يملك "المساءلة" في عصر لم يعد الخطأ فيه بشريًا بالكامل، فكما أن الذكاء الاصطناعي يعيد تعريف العمل والمعرفة، فإنه أيضًا يعيد تعريف المسؤولية.

المصادر: أرقام- الهيئة الوطنية لسلامة النقل الأمريكية- موقع ستات نيوز- لجنة الأوراق المالية والبورصات الأمريكية- موقع البرلمان الأوروبي الرسمي- وزارة الاقتصاد والتجارة والصناعة اليابانية- رويترز- صحيفة نيويورك تايمز

كن أول من يعلق على الخبر

تحليل التعليقات: